26 Dic La obligada ética de la Inteligencia Artificial

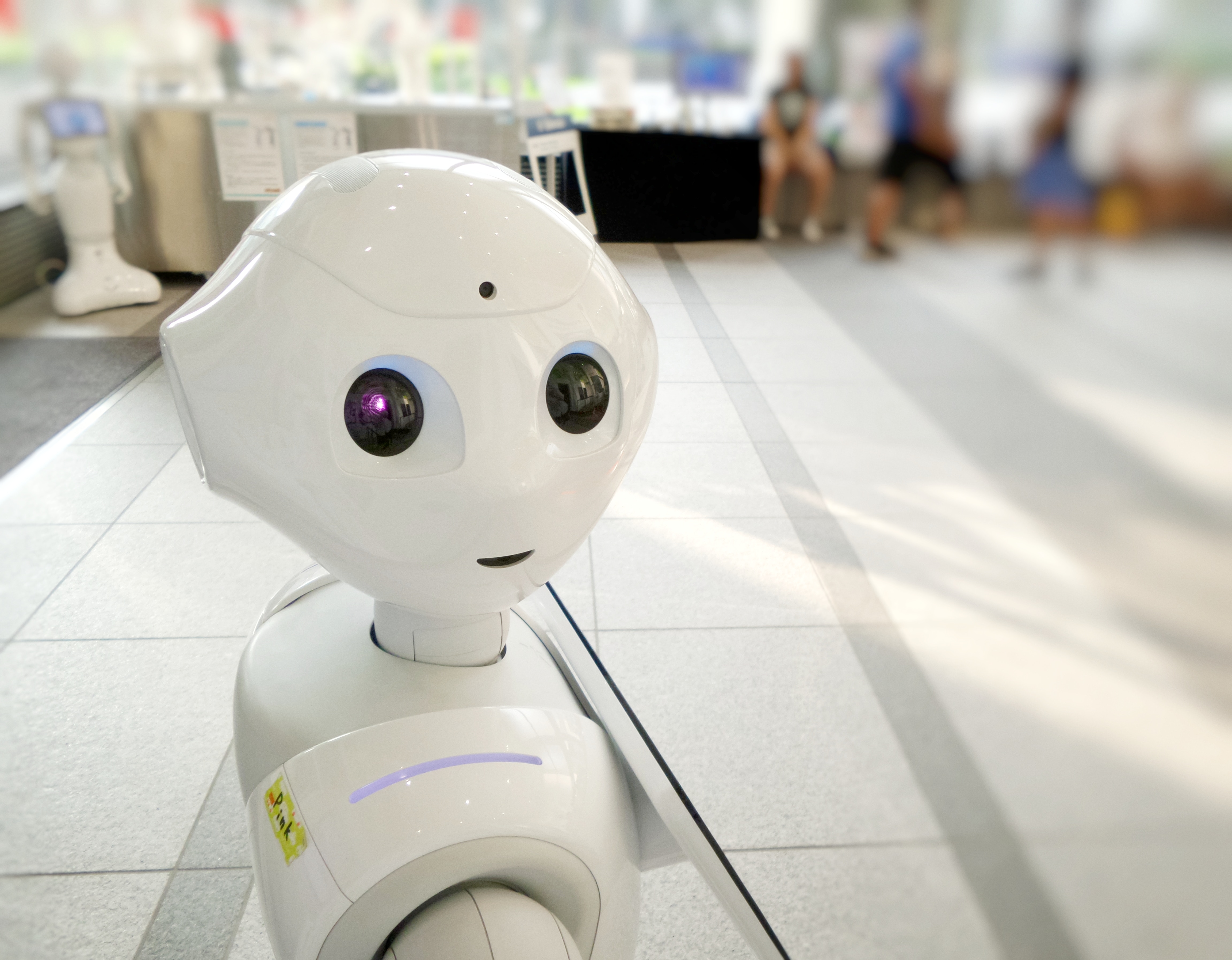

Ante el incremento de hoteles que se suman a la aplicación de sistemas que integran la Inteligencia Artificial (IA) en sus servicios, es conveniente no sólo conocer a qué tendencia se dirige el sector en este sentido sino ahondar en el cómo se está llevando a cabo su implementación. Al fin y al cabo, no cabe duda de que la inteligencia artificial y la robótica ya están aquí y, siendo así, más vale que sean utilizadas de forma ética y responsable.

EL POST EN 3 CLAVES

-

La Inteligencia Artificial permite a los hoteleros desarrollar servicios más personalizados y recabar mucha más información y más segmentada.

-

Ante el exponencial incremento de riesgos en el buen uso de esta información, la UE ha desarrollado el primer borrador de principios éticos en torno a la Inteligencia Artificial.

-

La supervisión, el respeto de la privacidad y la transparencia se alzan como las bases fundamentales para la aplicación de una Inteligencia Artificial ética.

“Un robot no hará daño a un ser humano o, por inacción, permitirá que un ser humano sufra daño. Un robot debe cumplir las órdenes dadas por los seres humanos, a excepción de aquellas que entrasen en conflicto con la primera ley”. Desde que en 1942 el autor de ciencia ficción Isaac Asimov formulara estas leyes de la robótica, la situación en esta materia ha cambiado hasta el punto que ya no se trata desde el ámbito de la ficción, la Inteligencia Artificial constituye una auténtica realidad. Tanto es así que la Unión Europea ha hecho público el primer borrador de principios éticos en torno a ella.

“Un robot no hará daño a un ser humano o, por inacción, permitirá que un ser humano sufra daño. Un robot debe cumplir las órdenes dadas por los seres humanos, a excepción de aquellas que entrasen en conflicto con la primera ley”. Desde que en 1942 el autor de ciencia ficción Isaac Asimov formulara estas leyes de la robótica, la situación en esta materia ha cambiado hasta el punto que ya no se trata desde el ámbito de la ficción, la Inteligencia Artificial constituye una auténtica realidad. Tanto es así que la Unión Europea ha hecho público el primer borrador de principios éticos en torno a ella.

Probablemente a menudo ni seamos conscientes, pero la IA, es decir, la simulación de procesos de inteligencia humana por parte de máquinas (especialmente de sistemas informáticos), está tan presente en la sociedad como lo está la automatización de respuesta que facilita el correo electrónico; el menú de sugerencias que ofrecen las plataformas de cine y series; el muro de los perfiles de redes sociales; y, por supuesto, el asistente de voz de algunos teléfonos móviles o de portales web. Detrás de todos ellos, existe IA.

El ámbito hotelero no es indiferente a este escenario y cada vez es más común el encontrar herramientas online para personalizar itinerarios de viaje; el uso de pulseras electrónicas para abrir las habitaciones y pagar los servicios del hotel y de los comercios que se encuentran a su alrededor; o, tal y como ha sido señalado recientemente en este blog por Carmen Martín López, al emplear chatbots, es decir, programas virtuales de conversación textual para la gestión de reservas de hotel. Aunque lo más llamativo es sin duda la instalación de asistentes virtuales para personalizar lo máximo posible la experiencia del huésped.

UN GRAN PODER CONLLEVA UNA GRAN RESPONSABILIDAD

En este contexto en el que los recursos de la IA están al alza, cabe recordar que un gran poder conlleva una gran responsabilidad. Por ello, del mismo modo que esta innovación tecnológica permite obtener una gran cantidad de información sobre nuestras vidas, hábitos y preferencias, posibilitando una elevada segmentación y personalización de la experiencia; también debe suponer un compromiso por parte de la empresa que la recibe para no cruzar ciertas líneas rojas establecidas dentro de su política de Responsabilidad Corporativa.

La importancia de consolidar una IA confiable ha llevado a la Unión Europea a trabajar en el desarrollo de una política tecnológica para su regulación, fruto de la cual la Comisión Europea ya ha hecho público el primer borrador de principios éticos en torno a la IA. El documento, elaborado por 52 expertos de los ámbitos académico, empresarial y de la sociedad civil, basa sus 37 páginas en los pilares de la supervisión, el respeto de la privacidad y la transparencia.

Divididos en dos bloques, el documento, por un lado, hace referencia a los principios éticos para el uso de la IA:

- Principio de beneficencia: “hacer el bien”.

- Principio de no maleficencia: “no hacer daño”.

- Principio de autonomía de los seres humanos.

- Principio de justicia.

- Principio de transparencia.

Y en su segunda parte, recoge un decálogo de los requisitos necesarios para desarrollar una Inteligencia Artificial de confianza, que enumera del siguiente modo:

- Responsabilidad.

- Gobierno de datos.

- Diseño para todos.

- Gobernanza de la autonomía de la Inteligencia Artificial.

- No discriminación.

- Respeto por la autonomía humana.

- Respeto a la privacidad.

- Robustez tecnológica.

- Seguridad.

- Transparencia.

A la espera de que la versión definitiva de este documento se publique en marzo de 2019, es importante tener presente este adelanto para un adecuado uso de la Inteligencia Artificial. Al fin y al cabo, cuando hablamos de ética hablamos de transparencia, de seguridad, de integridad e inclusión, principios tan valorados por los consumidores como la anteriormente mencionada personalización de los productos y servicios.